智能语音交互的产品思考(上)

(一)什么是语音交互界面(VUI)?

讨论语音交互界面(VUI),就不得不提大家耳熟能详的图形界面(GUI)。

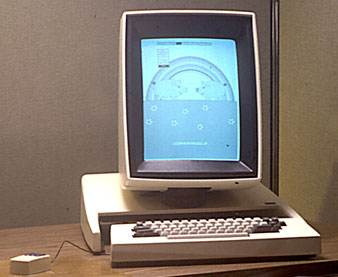

自从1973年施乐公司设计出第一个可操作的图形界面操作系统Alto以来,包括苹果、微软在内的各家公司相继推出支持图形界面的操作系统,使得GUI渐渐成为人机交互的主流形式。进入移动互联网时代,虽然交互手段由键盘鼠标变成了触控,但本质上交互仍然以GUI为载体进行。PC时代以后入行的产品经理和交互设计师,大部分时间都在和GUI打交道。

AI时代来临后,语音交互更多的被提起。2015年末至2016年,国内出现一波服务机器人创业潮,各种形态、功能各异的“机器人”频频占领科技新闻头条,这一时期的机器人简单点说就是把语音助手放进类人形硬件外壳,其主要交互方式正是语音交互。然而,这一波机器人浪潮并没有成功打开C端消费市场,而大洋彼岸的Amazon Echo却不断攻城略地,成为AI时代第一个名副其实的爆款单品。总之,后移动互联网时代,大家纷纷把目光瞄向未来,思考下一个可能的入口,而拥有语音交互功能的智能音箱逐步走向舞台中央。我们也渐渐在业内看到越来越多关于语音交互设计的讨论。

那么,当我们谈论语音交互时,我们到底在谈论什么?

语音交互界面的英文是VUI(voice user interface的缩写),与此相似的概念还有CUI(conversation user interface )、NLUI(natural language user interface)、LUI(language user interface)等等。这些概念大致相同但却有细微差异,比如NLUI或LUI是宽泛意义上的自然语言交互,含义最广;CUI重点则在对话,这里的对话狭义来看是指类似微信这样的聊天界面,2016年微软提出CAAP(conversation as a platform)的概念时,关注的更多也是在Skype生态里面的智能对话;VUI则专注语音,更多是指类似智能音箱这样通过声音去交互的用户界面。本文的讨论都是在VUI这个范畴内展开。

那么,如果考虑整个交互流程的输入输出,VUI事实上包含了三个技术环节:

- 语音识别(ASR)

- 语义处理(NLP)

- 语音合成(TTS)

个人认为,这个三个环节共同决定了语音交互的体验,任何一个环节有明显缺陷均会导致整体交互的满意度降低,缺一不可。

(二)为什么语音交互界面(VUI)被广泛关注?

讨论这个问题前,首先我们必须明白一个道理,即这么多年,互联网巨头在做的事情一直都是:抢入口、抢入口、抢入口。占据了入口就控制了用户流量,有了流量建立各种商业模式就会是水到渠成,这里不再赘述。

那么,从PC时代到移动互联网时代,再到后面的AI互联网时代,或者IOT时代,巨头们都先后争抢过哪些入口呢?我用下面这个表格总结一下:

从上往下,我把互联网切分成PC时代、移动互联网时代、AI过渡时代和AI互联网时代:

PC时代的平台显然是桌面操作系统,平台本身就是最大的入口,微软也凭借Windows赚的盆满钵满,但是在国内由于盗版的原因情况完全不同,各巨头争抢的是windows之上的次级入口。PC互联网时代的产品以网页形式存在,所以次级入口就集中在浏览器和搜索,围绕这一入口产生了百度、搜狗、360、遨游等公司。这个阶段的应用形态是网站,用户界面是网页页面。

移动互联网时代,各家都以APP的形式提供服务,移动搜索并没有继承桌面搜索的地位,用户需求也从信息搜索向服务搜索转移。周鸿祎大概在12年就看到了这个趋势,发力360手机助手,占据了应用分发的关键入口。同期的公司还有豌豆荚、91手机助手,以及后来的腾讯应用宝和百度手机助手。

但是到了移动互联网后期,APP市场饱和,用户手机中的APP基本稳定下来,用户很少再有搜索新应用的需求。此时应用市场的入口地位大大削弱。而业已存在的微信、头条等超级APP占据了大量用户时长,已成为实际上的新入口。这些超级APP依托流量优势,尝试在内部建立新生态,比如微信公众号、小程序、头条号,这些尝试本质上是希望在超级APP内重现桌面搜索的辉煌。

2016年的大洋彼岸,同样面临移动市场饱和困扰的美国巨头们也有了新的思考方向:3月份的build大会,微软首次提出了CaaP(Conversations as a Platform)的概念,并推出bot framework;4月份的F8大会,Facebook接力发布messager platform上的聊天机器人;5月Google I/O大会,Google推出了新一代语音助手Google assistant以及智能音箱Google home。这几家巨头的思考逻辑可以总结为:把移动IM这类超级APP(Skype、Messenger、Allo)作为新的入口,在其中引入bot生态(可以理解为对话版的微信公众号),在bot内用对话的形式提供服务;或者直接尝试强推语音助手(Cortana、Google assistant、Siri)使其成为手机上的新入口,在虚拟助手内通过对话服务用户。

后来的事情并没有按照这些巨头的预期发展,原因只有一个:Amazon Echo。这里面很有意思的点在于,巨头们都看到了AI或者语音交互的前景在布局,其他几家要么拥有几亿用户的超级IM(微软和FB),要么控制了手机或手机OS(Google和Apple),唯独Amazon在整个手机时代没有任何入口级优势。这也导致Amazon思考AI时直接抛弃掉手机生态,开发了智能音箱,而其他几家囿于既有优势失去先机。

Echo的火爆让AI或者IOT的前景变得更加清晰,那么新的平台和入口到底是什么呢?

我们转向用户角度思考这个问题。IOT时代万物互联,意味着你身边的任何设备都是联网的,你可以在任何地方、任何时间和任何设备交互(IOT的4A原则),所以IOT其实是去中心化的,手机当前的交互中心地位会被极大地削弱。未来计算平台的前台,是一系列形态、功能各异的智能硬件,这些硬件或大或小,有屏或无屏,近场或远场,位置固定或随身移动。虽然千差万别,用户却希望在任何一台设备上的交互状态可以云端同步至其他设备,用户可能随时在设备间切换,但希望交互进程和数据流不被中断、持续向前(集群智能)。那么,什么样的交互能够支撑这种切换需求、适配各类设备而又保证体验的一致性呢?从这个角度思考,我们很容易就能发现语音交互的独特优势。

事实上,语音交互对硬件的要求很低,最简的组成是mic+speaker+wifi+power,简易的语音交互模组成本可以做到几十块钱,这使得它在智能硬件中有极强的普适性。

IOT时代的硬件是非标准化的,所以在前台不会有安卓或者IOS这样的统一的操作系统,这个入口并不成立。但是,当用户和设备对话时其实是在和设备后的云端AI交互,如果有一天,所有智能设备背后的AI大脑都是同一个服务会怎么样呢?这就是alexa在做的事情,2017年CES,Amazon没有派任何员工到场,展会上也没有Amazon的展位,但是Amazon却接管了整个会场,因为参展的智能产品大多数都接入了Alexa的智能对话服务。所以AI云其实是存在于云端的下一代操作系统,这个操作系统正是IOT时代的计算平台,这个平台上的交互入口,可能是一个统一形象的无处不在的虚拟助理,也可能是分发各类bot的bot商店,也可能就是AI云本身。在国内,我们也看到了Duer OS这样的对话式操作系统,

小结一下,上文通过总结平台和入口的迁移,分析了IOT时代可能的新平台和新交互。我们看到,随着用户交互设备的去中心化演进,语音交互的优势逐步凸显,而提供语音交互能力的云端对话平台,最有希望成为下一代流量入口。

当然,语音交互受到广泛关注还离不开相关关键技术的成熟,但本文并不打算展开讨论技术进展。总体上,个人认为技术、交互、平台三者的关系是:新技术促进新交互,新技术+新交互拓展使用场景,进而催生新的计算平台。

(三)语音交互(VUI)有什么特性?

上文讨论了IOT时代语音交互独特的优势,但是需要特别说明的是:笔者并不认为语音交互是最好的交互方式。

虽然一直从事AI领域产品设计,但AI并不是我们的目的,AI其实只是我们的手段。进一步来说,AI并不是一个行业,而仅仅是一种技术,它是互联网的水和电而非业务本质。常有人说我是做人工智能的,其实仔细想想我们做的还是电商、社交、教育、医疗等等,只是我们应用了AI技术来优化这些业务的生产效率而已。

同样的,语音交互也只是我们的手段而非目的,所以切忌为了语音而语音,有太多的场

景下语音真的不是最优选择。

那么基于这个认知,我们必须要搞清楚的一点是:语音交互既然只是一种交互方案,那么这种方案到底有什么优势,有什么缺陷?这样我们才能进一步搞清楚,哪些场景适合使用语音交互,哪些场景应该避免使用语音交互。个人总结如下:

语音交互的优势:

- 解放双手、双眼、双腿,接触空间限制,远场可交互;

- 指向明确,语义直达目标,缩短使用路径

- 自然简单人性化,学习门槛低

- 可以1对1,也可以1对多

- 对设备要求低

语音交互的劣势:

- 不适用于选择多、流程长、需要大量辅助信息决策的交互任务

- 远场语音交互对距离、噪音、混响、声源数量等等有一系列要求

- 一般不适用于公共场所,尤其是需要安静的尝试(图书馆、会议室)

- 依赖嘴巴和耳朵,受限语种、口语和发音,部分人群受限

- 输出信号单一,表现力有限

我们发现,语音交互虽然有很多突出的优点,但其缺陷同样明显,在产品设计中一定要还原清楚用户使用场景,到底适不适合用语音,扬长避短。

那么,到底在哪些领域适合提供语音交互功能呢?

(四)语音交互(VUI)适合的人群和领域

1.语音交互适合的人群:

事实上,语音交互对人群的要求真的很低,只要具备基本的语言表达能力和倾听理解能力的人群,都是语音交互的适合人群。

不仅如此,在以往的互联网时代被忽略的特殊人群,却极有可能在语音交互浪潮中收益,这些人群包括:

- 老年人(不会上网,不会用手机、不会打字)

- 儿童(和老年人类似)

- 盲人等残障人士(看不见,动不了,但能说能听)

- 行动不便的病人或孕妇(移动不便,不宜近场使用辐射设备)

2.语音交互适合的场所:

讨论这个问题前还要提一下,语音交互可以分为近场和远场两种形态。近场语音交互最近提的比较少,原因是近场语音识别基本上是已经解决的问题,如果你还没有使用习惯可以去体验一下搜狗、讯飞这类语音输入法,识别的准确率往往会大大超出你的预期。但是,当交互距离变大(3-5m)时,语音识别需要解决的问题事实上已经完全不同,需要借助一系列的前端声学处理,这就是麦克风阵列及其算法如此重要的原因。

当我们罗列语音交互适合的场所时,发现近场和远场有一定的区别,这里分开来说。

远场语音交互适合的场所,一般都是偏私密的场合,参考上文提到的VUI的优势和劣势,很容易得到这个结论。那么这些场所有哪些呢?

- 家里:客厅、卧室、餐厅、洗手间

- 车里

- 外部私密空间:酒店房间、办公室、各种包间、各种mini吧等等

近场语音交互则完全不同,这种交互除了手机、遥控器外,大多出现在可穿戴设备上,比如智能手表、智能耳机、智能眼镜、VR、AR等等。当你随身携带一个近场语音交互设备时,场所的局限远没有远场那么大,即时是在一些公共场所也没有问题。罗列几个典型场景:

- 公园跑步

- 操场运动

- 健身房健身

- 客厅里的语音遥控器

3.语音交互适合的领域

其实通过上文的讨论,答案已经非常明确,语音交互有广阔应用场景的三大核心领域是:

- 智能家居

- 智能车载

- 智能穿戴(包含手机)

除了这些核心领域外,还有一些值得关注的方向:

方向一:特殊人群领域

- 老年人陪护

- 儿童教育

- 盲人陪护

这里面本人非常看好的是盲人领域,具体可以参考锤子的坚果pro2发布会。

方向二:业务形态本身和“对话”形态接近

- 客服

- 咨询

- 教育

- 翻译

- 音乐电台

- 新闻资讯

- ……

方向三:一些B端的整体解决方案。

这一块比较复杂不再罗列,有机会后面可以分享。

到这里,我们已经系统讨论了语音交互界面(VUI)的定义、语音交互火爆的原因、语音交互的特性,以及语音交互适合的领域。那么下一个问题呼之欲出:如何设计一个好的语音交互功能?我将会在下篇文章中和大家一起详细讨论。