ICLR2022文章速览(二)

Multi-objective Optimization by Learning Space Partition

(文章链接Multi-objective Optimization by Learning Space Partition,Poster Session 6,加州时间4月26日周二下午6点30分,北京时间4月27日周三上午9点30分)

多目标黑盒优化(Multi-objective Black-box Optimization)在很多实际问题和应用中都能看到其身影。例如如何最大化汽车引擎的性能且让其能耗最小,如何平衡电池的容量和尺寸,如何在尽可能减小风险的条件下获得最大效益的投资。不同于单目标优化,多目标优化由于不同目标间存在内在的冲突,所以多目标优化结果是得到一个最优解集合(Pareto-frontier)而不是单一的最优解。因其应用广泛,一直在各类领域和研究方向上受到人们的关注。

本篇ICLR是之前一系列learning-to-partition(基于学习的搜索空间切分)这个方向工作的后续,包括LaNAS (TPAMI'21), LaMCTS (NeurIPS'20),LaP^3 (NeurIPS'21)。这次我们将这个方向做到了多目标优化上面。

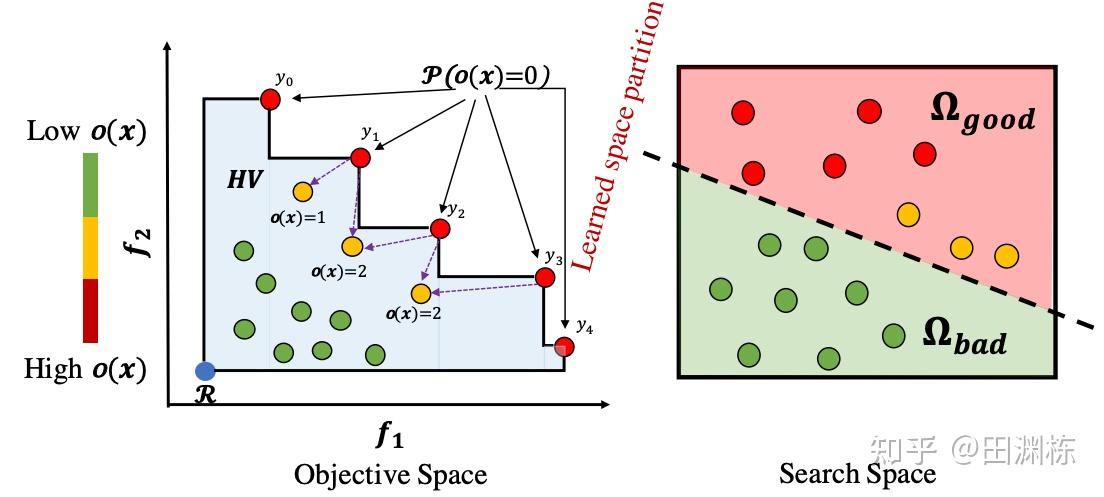

具体来说,我们提出了LaMOO,利用采样的支配数目(Dominance Number)学习出一个边界,将当前搜索空间分割为好的和坏的子区域,并不断的重复这一步直到区域足够小。然后利用蒙特卡洛树搜索选出相应的子区域进行采样,从而实现多目标的黑盒优化。在一个小的区域里,我们依然可以结合贝叶斯优化或者进化算法进行采样,大幅提升了样本搜索效率。

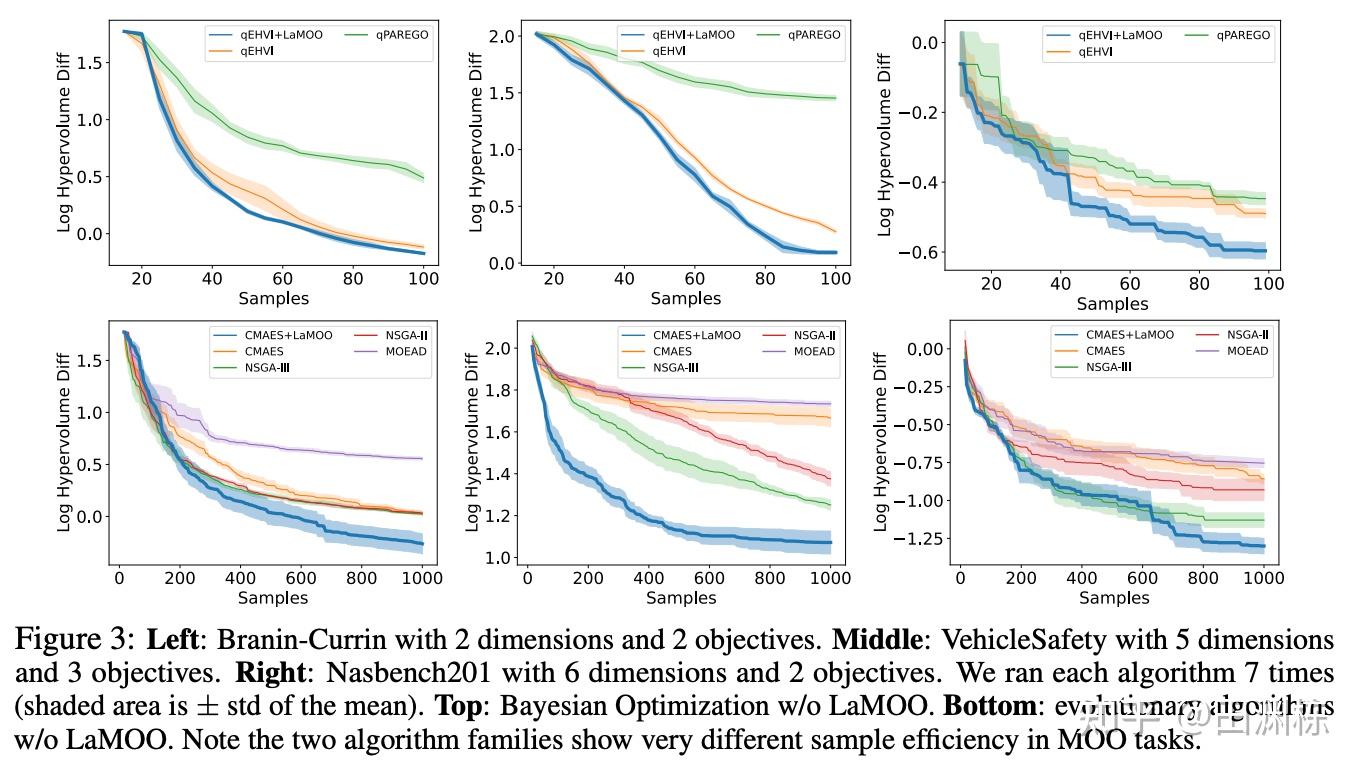

LaMOO简单易行,且可以作为元算法(meta-algorithm)与其它优化算法(例如进化算法和贝叶斯优化)相结合,实验证明,LaMOO在不同函数和实际任务中大幅度提升多种类优化算法的搜索效率。在小规模问题中(输入维度小于10且目标维度小于等于3),LaMOO大幅度提升了进化算法(CMAES)和贝叶斯优化(qEHVI)的样本搜索效率。

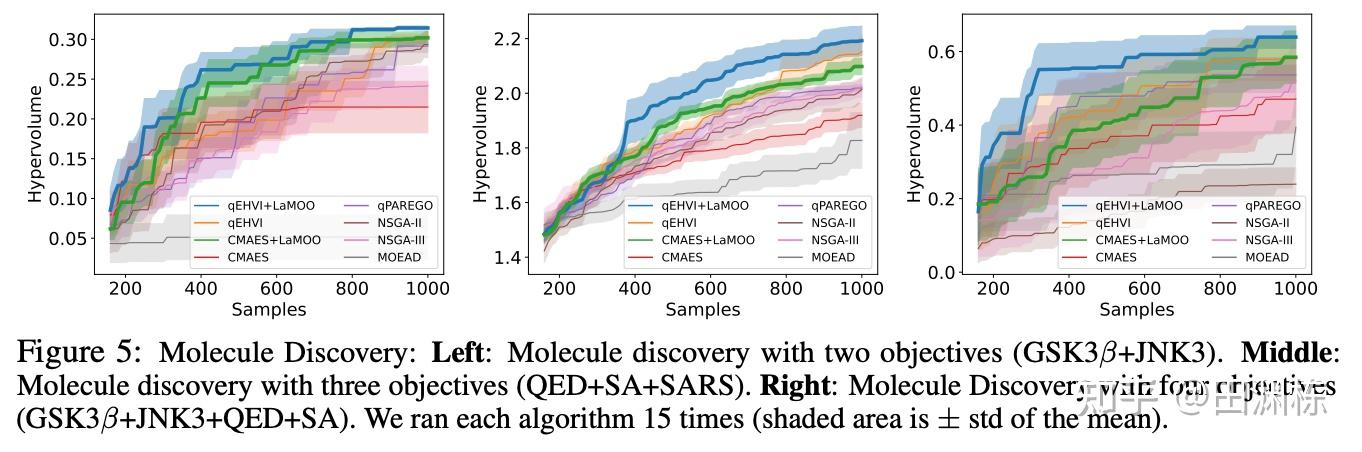

我们在实际问题(如发现满足多种准则的分子,Molecule Discovery)中, LaMOO也取得了很好的搜索效果。

LaMOO的代码将在近期开源。

关于learning-to-partition这个思想其实可以往下挖很深。相比事先定义好某个马尔可夫决策过程(MDP),跑一跑强化学习算法这样的习惯性思维,其实每一个实际问题都可以对应无数个不同版本的MDP,究竟哪个比较好是更本质的问题。这个等我有空,会写一个专栏讨论。

如果说强化学习是解决大问题的攻城重武器,基于学习的优化算法就是便携式轻量级工具,可以在各种应用中发挥作用,欢迎大家使用!