Chatbot专栏(090)——智能音箱的安全问题

随着近年语音识别相关技术的大发展,智能音箱作为人机交互的下一个主要的载体,正在逐渐敲开各家家门。但是智能音箱的安全问题,现在还未被大众和相关厂商重视。

智能音箱的安全问题主要分为两个大的块,一是传统的软件安全,另一个是与AI相关的算法安全。

一、传统的软件安全

智能音箱作为一个软件存在,所有传统软件的安全问题都可能存在。包括固件的更新完整性保护,系统安全配置不当,系统补丁更新不及时,高危漏洞不修复等。

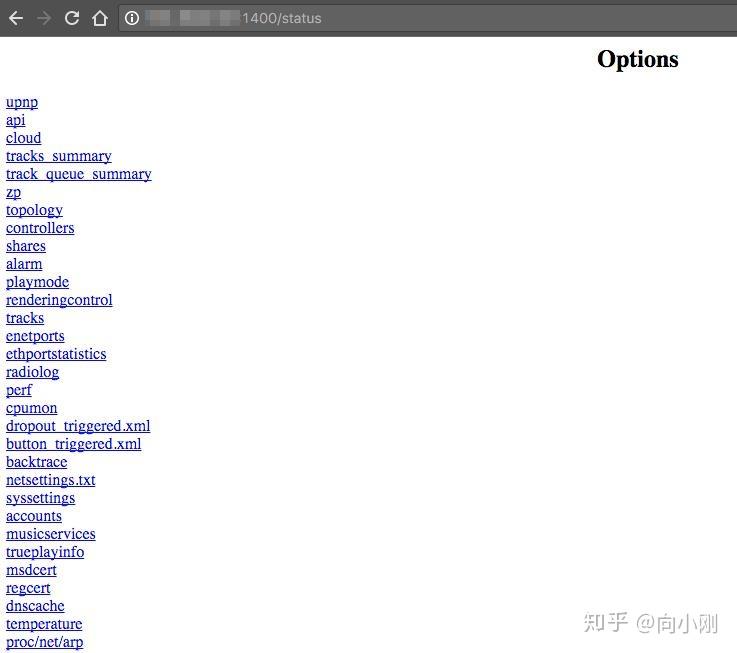

前不久爆出某智能音箱产品把配置界面暴露在公网上。攻击者通过在线扫描进入就可收集本地网络信息,或者指定音响播放任意的音频文件。

智能音箱一般都有对应的APP,APP安全防护缺失,用户敏感信息明文传输等问题也需要注意。

如果智能音箱还有其他的外部设备,比如摄像头,屏幕等,对文件,对网络协议的处理都可能出问题,更容易成为攻击的对象。如果音箱被黑客控制的话,就可能会变成窃听器,摄像头如果被黑掉,也可能被用来监视我们。

前不久,微软语音助手Cortana被爆出可以攻击锁屏装下的Windows 10系统,可以执行任意代码,包括修改用户密码等。

二、AI算法安全

1.底层框架安全

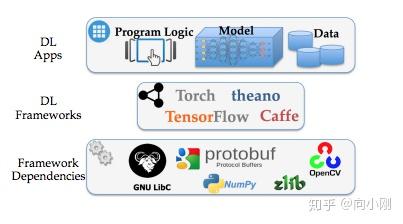

深度学习框架的出现,让编写深度学习程序更佳的方便,也带来了一些安全问题。出现漏洞更多的是深度学习框架依赖的开源项目库。

上面列了一些深度学习框架所依赖的库,包括很多非常有名的开源项目。下面是这些开源项目的一些CVE列表。

如果是底层框架的漏洞,其破坏力是非常强大的。尽管开源社区在不断提高软件的质量,漏洞是很难避免的,厂商应该实时关注并及时修复相关漏洞。

2.内容安全

智能音响作为一个人机交互的产品,内容安全是非常重要的。对于输入和输出敏感的内容需要一个过滤系统来完成相关的处理。

如上图所示,智能音响的输出中,如果包含了难以接受的行为是非常影响用户体验。而如果训练的样本数据被污染,则可能会引发更大的问题,比如种族歧视言论等。

小冰训练的样本数据被污染

Tay 发表种族歧视的言论

3.模型安全

用于欺骗神经网络的对抗样本是最近比较热的研究方向。开始的对抗样本主要在计算机视觉领域流行,主要分为非定向攻击和定向攻击。

非定向攻击是指只要干扰分类的结果,在多分类的场景下,主要分类到其他的类别就算攻击成功

单像素攻击是只修改一个像素就可将图片错误的分类的一种攻击手段

定向攻击是指对抗样本需要把分类的结果定向为指定的另一类结果。

在上图中,鸟的图片被分类成为飞机,定向攻击成功

对抗样本生成方法如下图

图像识别

在智能音箱的场景下,可以攻击人脸识别场景。人脸识别中的对抗样本构造,如下图所示

语音识别

对于智能音箱来说,语音识别是最重要的基础功能,对于语音识别的攻击也有很多的进展。

攻击者可以轻易将指令伪装成轻微的失真噪音,植入你播放的音乐、视频或有利专注工作的白噪音等,让人耳无法察觉。秘密指令可以指示你的音箱做各种事情,比如拍照、打电话或者购物。

上图为攻击原理展示

有研究者也发现,只要将语音指令变成「海豚音」就能轻易骗过语音助手。方法是将人声语音指令转换为频率高于 20,000 Hz 的超声波,这是人耳完全听不见的声音,但智能喇叭都能听懂。

上图为研究团队攻击图

声纹识别

现在越来越多的智能音响启用了声纹识别的功能,声纹识别系统也是可以被攻击的。

1.熟人模型攻击

熟人模仿你的声音去攻击你的声纹账号,通过概率会有提升

2.重放攻击

你的声音被录下来,然后在声纹登录时播放你的声音。此攻击可以被活体检测和随机内容声纹防范。

3.特定人声合成或者声音转换

利用机器学习、深度学习等技术,通过对目标人的一段录音进行建模,学习出目标人的声音特质并将其参数化,然后将非目标人的声音合成并转化为目标人的声音进行攻击。现在Google的Tacotron,百度的ClariNet等端到端的TTS方法的出现,极大的提高了声音合成的真实度,对声纹识别算法造成了潜在的威胁。

4.loT安全

智能音箱作为家庭的入口,对智能家居的控制是一个非常基础的功能。家庭里的一些智能设备的安全性亟待提高,包括对文件的处理,对网络协议的处理,各种外部输入协议的处理都可能会出问题。这种问题会通过智能音箱这个入口被放大,比如可以通过音箱控制智能锁,那么远程开锁是可以实现的。很多的智能音箱还可以控制车载的一些设备,对汽车的安全行驶也带来了威胁。

三、解决方案

作为厂商,开始考虑一个安全解决方案,都是需要有成本的考量。对于智能音箱的安全问题,厂商需要有足够的重视,在安全和成本之间选一个平衡点加以投入。

应该重视传统的软件安全,比如硬件安全,app安全,服务器安全等,在这些传统的安全领域建立安全跟踪,测试和修复机制,杜绝自动化扫描器可以利用的漏洞出现。增大对用户相关的隐私保护,对内容过滤系统进行完善,提高用户体验。

对于AI算法安全,可以跟踪相关新闻并测试自家产品。如果是对安全要求较高的产品,比如金融支付类产品,需实时关注此类威胁,建立威胁情报平台及时响应未知威胁,减少攻击造成的损失。

对于个人用户,尽量选择知名厂家产品,包括智能音箱和loT设备,并根据说明书上的配置加以强化隐私保护。

智能音箱所受到的欢迎,让国内外的厂商都积极的跟上研发自己的智能音箱产品。但是从另外一个角度来说,用户的隐私和安全是第一位的,只有研究好了攻,才知道怎么去防御它。

参考资料:

1.Audio Adversarial Examples: Targeted Attacks on Speech-to-Text

https://arxiv.org/pdf/1801.01944.pdf

2.CVE-2018-8140

https://portal.msrc.microsoft.com/en-US/security-guidance/advisory/CVE-2018-8140

3.The Need for Better Built-in Security in IoT Devices

4.Security Risks in Deep Learning Implementations

https://arxiv.org/pdf/1711.11008.pdf

5.Threat of Adversarial Attacks on Deep Learning in Computer Vision: A Survey

https://arxiv.org/abs/1801.00553

6.One pixel attack for fooling deep neural networks

https://arxiv.org/abs/1710.08864

7.Tacotron : An end-to-end speech synthesis system by Google

https://google.github.io/tacotron/

后记:此文写于2018年6月,很多内容已有最新发展,待后续更新,敬请关注

欢迎关注我的公众号:AI与安全

此文公众号链接: